Intelligenza Artificiale Generativa e Intelligenza Umana: in cosa saranno diverse?

TEORIE > METODI > INTELLIGENZA ARTIFICIALE

Scopo di questa pagina

L'approccio classico alla AI, conosciuto come "knowledge base" consiste nell'utilizzo di linguaggi formali che impiegano automaticamente regole logiche di inferenza. Questo è l'approccio degli albori dell'intelligenza artificiale. Il termine "intelligenza artificiale" fu infatti coniato nel 1955 dallo scienziato informatico John McCarthy che ne diede la seguente definizione: "L'intelligenza artificiale è quella scienza che consente di costruire macchine intelligenti, in particolare programmi per computer intelligenti. Essa è legata a compiti simili a quelli che utilizzano computer per capire l'intelligenza umana, ma la AI non deve limitarsi a metodi che sono biologicamente osservabili. " Con il tempo ci si accorse che la vera sfida che la AI doveva affrontare era un'altra, cioè quella di acquisire le proprie conoscenze estraendo strutture ("pattern") da dati grezzi esterni. Questa capacità di apprendimento automatico venne denominata "Machine Learning". Il Machine Learning si può definire un software che crea degli algoritmi che migliorano le proprie prestazioni nel corso del tempo, quando vengono misurati nell'ambito di un compito specifico, dopo aver effettuato una serie di esperienze. La AI doveva dunque imparare a risolvere problemi che l'uomo risolve facilmente in modo intuitivo (automatico), come riconoscere parole o volti nelle immagini, ma che non possono essere descritti matematicamente. Dato che non esistono regole per quest'attività, occorreva imparare dall'esperienza. Se la conoscenza proviene dall'esperienza si può fare a meno dell'intervento umano, infatti i computer possono funzionare nei termini di gerarchie di concetti, dove ogni concetto può essere definito con le sue relazioni a concetti più semplici, e il computer può imparare nuovi concetti complessi costruendoli dall'aggregazione di altri più semplici che già possiede. Secondo lo scienziato e filosofo Jürgen Schmidhuber lo sviluppo di reti neurali, cioè di reti che simulano il comportamento delle reti neurali biologiche, ha consentito il grande sviluppo del "Deep learning", cioè di un apprendimento automatico che richiede lunghe catene causali di fasi computazionali. L'apprendimento consiste nell'assegnazione di pesi corretti alle connessioni che portano la rete neurale verso il risultato desiderato. Il Deep Learning è un processo che continuamente valuta e assegna credito a molte fasi computazionali interconnesse (come il cervello umano). Il canto del gallo provoca l'alba? La risposta è ovvia, se sei un essere umano, ma una macchina può solo capire che il canto del gallo e l'alba sono correlati, non che uno causa (o non causa) l'altro. L'inferenza causale o ragionamento causale è oggi assente dai meccanismi di machine learning presi in considerazione dagli esperti di Intelligenza Artificiale, eppure essa è l'inferenza più rappresentativa dell'intelligenza umana perché implica la previsione degli effetti delle proprie azioni. Noi viviamo in un mondo reale nel quale possiamo fare le nostre osservazioni e le nostre azioni, ma la nostra specie è l'unica che può vivere, mentalmente, in più "mondi possibili". Questa straordinaria capacità ha dato all'essere umano la possibilità di immaginare e, successivamente, realizzare artefatti, prodotti, stili di vita che ci hanno portato fin qui. Dato che l'intelligenza artificiale si occupa del futuro, la scala della causalità rappresenta, secondo la visione del filosofo Judea Pearl, l'evoluzione del pensiero umano. Molto presto nella nostra evoluzione, noi umani ci siamo resi conto che il mondo non è fatto solo di puri fatti (quelli che oggi potremmo chiamare dati); piuttosto, questi fatti sono uniti da una intricata rete di relazioni causa-effetto. Spiegazioni causali, non puri fatti, costituiscono la maggior parte delle nostre conoscenze. Il tecnologo e filosofo David Weinberger, esaminando i risultati del confronto tra intelligenza umana e intelligenza artificiale, di fronte alla maggiore correttezza dei risultati della AI ma anche alla sua inspiegabilità umana, conclude che la AI cambierà anche il "metodo scientifico" così come noi lo conosciamo. La promessa del machine learning è che ci sono volte in cui i modelli imperscrutabili delle macchine saranno molto più predittivi di quelli costruiti manualmente. In questi casi la nostra conoscenza, se scegliamo di usarla, dipenderà da giustificazioni che, forse, non saremo in grado di capire. La sociologa Soshana Zuboff ipotizza la trasformazione che l'Intelligenza Artificiale opererà sulla società e la descrive così: "Il potere strumentalizzante del "Grande Altro" è quello che riduce l'esperienza umana a un comportamento osservabile e misurabile, rimanendo indifferente al significato di tale esperienza." Gli individui vengono ridotti al minimo comune denominatore, organismi tra gli organismi. Non c'è alcun fratello, grande o piccolo che sia, buono o cattivo, non ci sono legami familiari, nemmeno dei peggiori. Non ci sono relazioni tra il "Grande Altro" e gli individui resi oggetti-altri. Il "Grande Altro" non si cura di quel che pensiamo, sentiamo o facciamo, basta che milioni, miliardi, migliaia di miliardi di occhi e orecchie senzienti, attivanti e computazionali, possano osservare, renderizzare, trasformare in dati e strumentalizzare i grandi serbatoi di surplus comportamentale generati nel marasma galattico di connessioni e comunicazioni. In questo nuovo regime, le nostre vite si svolgono in un contesto morale di oggettificazione. Il "Grande Altro" può imitare l'intimità per mezzo dell'instancabile devozione dell'Unica Voce - la ciarliera Alexa di Amazon, le informazioni instancabili e i promemoria del Google Assistant". Ed è proprio questo il motivo per cui l'Intelligenza Artificiale è "stupida" e lo sarà sempre. Sarà, per l'essere umano un "utile idiota", rapido e potenzialmente veritiero ma privo delle caratteristiche emotive, etiche ed epistemiche che caratterizzano ogni essere umano. Ma siamo proprio sicuri, cinicamente, che ci attenda un futuro morale di oggettificazione, come paventa la Zubova, o l'essere umano riuscirà a imporre la propria vera natura? L'AGI (Artificial General Intelligence) resterà un utile idiota?

In conclusion, the new is coming forward or not?

Difficult to say: no one distinguishes which is the head and which is the ass.

Difficult to say: no one distinguishes which is the head and which is the ass.

Punto chiave di questa pagina

IL FUTURO DI CHAT GPT E DELL'INTELLIGENZA ARTIFICIALE GENERATIVA: Oggi si attribuisce grande attenzione e speranza a Chat GPT, ma a me non sembra che essa possa dare grandi risposte, probabilmente perché ad essa mancano (e mancheranno anche in futuro) molte caratteristiche umane quali: esperienza, consapevolezza, identità, agentività, emotività, ecc. Eppure, gli attuali progettisti di Chat GPT ci credono (vedi in bibliografia articolo MIT 26 ottobre 2023).

Punti di riflessione

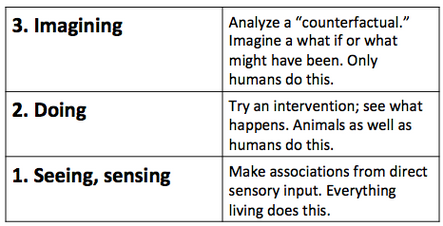

II giorno in cui l’Intelligenza Artificiale saprà approssimarsi all'intelligenza umana è vicino, ma le sue capacità vanno giudicate su tre livelli di abilità cognitive: vedere (associazione), fare (intervento) e immaginare (controfattuali). L’IA oggi lavora solo al livello più basso, cioè, vedere. (Judea Pearl, Dana MacKenzie)

_

_

Il futuro della intelligenza artificiale è costituito dallo sforzo di costruire computer che, come gli esseri umani, imparino dall'esperienza, senza la necessità di matematizzare ogni passo.

_

La natura delle giustificazioni basate sul computer non è affatto come le giustificazioni umane. E' aliena. Ma "aliena" non significa "sbagliata". Quando si tratta di capire come stanno le cose, le macchine possono essere più vicine alla verità di quanto noi umani potremo mai essere. (David Weinberger)

_

Il metodo scientifico umano, basato sull'osservazione di fenomeni, generazione di ipotesi e verifiche sperimentali, viene annullato dalla modalità di funzionamento delle applicazioni di intelligenza artificiale basate sul "machine learning". Esse non producono ipotesi nè fanno verifiche (visibili all'uomo) eppure danno risultati più attendibili, ma incomprensibili all'uomo.

_

L'IA, oggi, è solo in grado con molta ma molta più efficienza dell'uomo, di rilevare strutture significative all'interno di basi dati anche molto ampie. (Judea Pearl)

_

I mondi possibili sono cose di cui possiamo parlare o che possiamo immaginare, ipotizzare, in cui possiamo credere o che possiamo auspicare. Tuttavia, non possiamo mai arrivare in un mondo possibile che non sia il mondo reale; perchè, se potessimo, e richiede solo che si pensi un attimo alla fantascienza per vedere come potremmo pensare di potere, allora quel mondo sarebbe parte del mondo reale. Le cose stanno così in quanto il mondo reale non è altro che la totalità di ciò che accade nella realtà. (M.J. Cresswell)

_

La modellazione causale non è in prima linea nell'attuale lavoro di machine learning. L'apprendimento automatico oggi è dominato dagli statistici e dalla convinzione di poter imparare tutto dai dati. Questa filosofia incentrata sui dati è limitata. (Judea Pearl)

_

I dati possono aiutarci a prevedere cosa accadrà, ma anche l'apprendimento automatico più sofisticato di oggi non può dirci perché. (Judea Pearl)

_

Mentre la consapevolezza della necessità di un modello causale è cresciuta a passi da gigante tra le scienze, molte ricerche sull'intelligenza artificiale vorrebbero evitare il difficile passo della costruzione e acquisizione di un modello causale e fare affidamento esclusivamente sui dati per tutti i compiti cognitivi. (Judea Pearl)

_

In cosa differiscono l'intelligenza umana e quella Artificiale? "Nella capacità di porre domande e trovare risposte". Contrariamente a quanto si potrebbe pensare la capacità più importante è quella di "porre domande", infatti è facile constatare che la maggior parte delle persone non si pone nessuna domanda o, quando lo fa, si tratta di domande con scopi pratici. (Judea Pearl)

_

Il merito del bel libro di Crawford [IA: nè intelligente nè artificiale] è quello di rendere estremamente visibile l’infrastruttura planetaria che si nasconde dietro lo sviluppo e la diffusione di sistemi di IA e di rappresentarci questa infrastruttura come la versione contemporanea di precedenti forme di industria estrattiva. La creazione di sistemi di IA è strettamente legata allo sfruttamento delle risorse energetiche e minerarie del pianeta, di manodopera a basso costo e di dati su amplissima scala (p. 22). Non c’è niente di immateriale nelle cloud dove sono archiviati i nostri dati, non c’è niente di immateriale negli algoritmi che ci suggeriscono cosa ascoltare su Spotify o vedere su Netflix. Kate Crawford, attraverso numerosi viaggi di ricerca che abbracciano un arco temporale di dieci anni, di cui questo libro è il frutto, ci mostra come l’intelligenza artificiale “nasce dai laghi salati della Bolivia e dalle miniere del Congo, ed è costruita a partire da set di dati etichettati da crowdworkers che cercano di classificare azioni, emozioni e identità umane. (Tiziano Bonini)

-

ChatGPT è uno di quei rari momenti nella tecnologia in cui vedi un barlume di come tutto sarà diverso in futuro.

Quella meraviglia crolla non appena ChatGPT dice qualcosa di stupido. Ma a quel punto non importa. Questo assaggio di ciò che era possibile è sufficiente, dice Sutskever. ChatGPT ha cambiato gli orizzonti delle persone. (Will Douglas Haven)

-

La cultura popolare ha portato le persone a pensare a distopie in cui l’intelligenza artificiale abbandona le catene del controllo umano e assume una vita propria, come hanno fatto i cyborg alimentati dall’intelligenza artificiale in “Terminator 2”. Ma queste preoccupazioni sono – almeno per quanto riguarda i grandi modelli linguistici – infondate. ChatGPT e tecnologie simili sono sofisticate applicazioni per il completamento delle frasi: niente di più, niente di meno. Le loro risposte inquietanti dipendono da quanto sono prevedibili gli esseri umani se si dispone di dati sufficienti sui modi in cui comunichiamo. (Nir EisiKovits)

-

Bisogna capire che l’intelligenza umana e quella artificiale non sono la stessa cosa: entrambe hanno la capacità di essere razionali e sistematiche, ma solo la mente umana è anche emozionale, sensoriale, immaginativa. Cerchiamo di essere ancora più chiari prendendo in esame il Machine Learning. Una mente artificiale in grado di apprendere autonomamente può monitorare gli umori delle persone grazie a opinion mining e sentiment analysis, ma non potrà mai avvertire sentimenti come l’amore o l’amicizia, provare emozioni come quelle che si provano prima di un lungo viaggio o recepire la bellezza dei quadri di Botticelli o delle rovesciate di Cristiano Ronaldo. A meno che non glielo si insegni. (injenia)

-

Oggi lo studio della mente è un'attività molto in voga. Non sono certo i computer o i supercomputer quantistici ad aiutarci nell'intento. Non è che l'intelligenza artificiale a farlo, che neanche troppo "intelligenza" è. Ai computer manca la coscienza, manca l'intuizione, manca la conoscenza del mondo, quindi non saranno certo loro a dare una nuova strada. La nuova strada nasce dallo studio di tutto quello che ha dato il via a questo processo. Dalle esperienze che sono state vissute. (Gabriella Greison p.198 del libro "Ogni cosa è collegata)

Come funzionano la mente umana e quella artificiale

Subito dopo la seconda guerra mondiale, agli albori di questo campo di studi avviato dal matematico Alan Turing, l'intelligenza artificiale (AI - artificial intelligence) aspirava solo a risolvere problemi difficili per gli umani, ma relativamente facili per dei computer, cioè problemi che potessero essere descritti da una lista di regole matematiche (ad esempio il supercomputer IBM’s Deep Blue che sconfisse il campione di scacchi Garry Kasparov nel 1997). Inizialmente la AI si proponeva di risolvere problemi pratici quali automatizzare routine di processi produttivi, riconoscere testi o immagini, fare diagnosi mediche, supportare la ricerca scientifica di base, e altri compiti di questo tipo.

L'approccio classico alla AI, conosciuto come "knowledge base" consiste nell'utilizzo di linguaggi formali che impiegano automaticamente regole logiche di inferenza. Questo è l'approccio degli albori dell'intelligenza artificiale. Il termine "intelligenza artificiale" fu infatti coniato nel 1955 dallo scienziato informatico John McCarthy che ne diede la seguente definizione:

L'approccio classico alla AI, conosciuto come "knowledge base" consiste nell'utilizzo di linguaggi formali che impiegano automaticamente regole logiche di inferenza. Questo è l'approccio degli albori dell'intelligenza artificiale. Il termine "intelligenza artificiale" fu infatti coniato nel 1955 dallo scienziato informatico John McCarthy che ne diede la seguente definizione:

L'intelligenza artificiale è quella scienza che consente di costruire macchine intelligenti, in particolare programmi per computer intelligenti. Essa è legata a compiti simili a quelli che utilizzano computer per capire l'intelligenza umana, ma la AI non deve limitarsi a metodi che sono biologicamente osservabili.

Lo stesso McCarthy diede della "intelligenza umana" la seguente definizione:

L'intelligenza umana è la parte computazionale della capacità di raggiungere degli obiettivi nel mondo. Vari tipi e gradi di intelligenza si riscontrano nelle persone, in molti animali e in alcune macchine.

Alcune questioni basilari sulla differenza tra intelligenza umana e artificiale sono state date da McCarthy (ad esempio se il quoziente IQ è applicabile anche alle macchine, oppure cos'è il Turing Test, ecc) e sono reperibili qui.

I dati possono aiutarci a prevedere cosa accadrà, ma anche l'apprendimento automatico più sofisticato di oggi non può dirci perché

L'Intelligenza Artificiale, oggi, è solo in grado con molta ma molta più efficienza dell'uomo, di rilevare strutture significative all'interno di basi dati anche molto ampie

Invenzione del "Machine Learning" e del "Deep Learning"

Con il tempo ci si accorse che la vera sfida che la AI doveva affrontare era un'altra, cioè quella di acquisire le proprie conoscenze estraendo strutture ("pattern") da dati grezzi esterni. Questa capacità di apprendimento automatico venne denominata "Machine Learning". Il Machine Learning si può definire un software che crea degli algoritmi che migliorano le proprie prestazioni nel corso del tempo, quando vengono misurati nell'ambito di un compito specifico, dopo aver effettuato una serie di esperienze. I più quotati corsi e tutorial universitari americani sono riportati qui.

Il tecnologo Daniel Faggella (vedi bibliografia) ha dato dell'apprendimento automatico delle macchine la seguente definizione:

Machine learning è la scienza che permette ai computer di imparare ed agire come gli umani, e di migliorare il proprio apprendimento nel tempo autonomamente, se essi vengono alimentati di dati e informazioni in forma di osservazioni e interazioni con il mondo reale

La AI doveva dunque imparare a risolvere problemi che l'uomo risolve facilmente in modo intuitivo (automatico), come riconoscere parole o volti nelle immagini, ma che non possono essere descritti matematicamente. Dato che non esistono regole per quest'attività, occorreva imparare dall'esperienza. Se la conoscenza proviene dall'esperienza si può fare a meno dell'intervento umano, infatti i computer possono funzionare nei termini di gerarchie di concetti, dove ogni concetto può essere definito con le sue relazioni a concetti più semplici, e il computer può imparare nuovi concetti complessi costruendoli dall'aggregazione di altri più semplici che già possiede. Secondo lo scienziato e filosofo Jürgen Schmidhuber (vedi bibliografia) lo sviluppo di reti neurali, cioè di reti che simulano il comportamento delle reti neurali biologiche, ha consentito il grande sviluppo del "Deep learning", cioè di un apprendimento automatico che richiede lunghe catene causali di fasi computazionali. L'apprendimento consiste nell'assegnazione di pesi corretti alle connessioni che portano la rete neurale verso il risultato desiderato. Il Deep Learning è un processo che continuamente valuta e assegna credito a molte fasi computazionali interconnesse (come il cervello umano).

Il Deep Learning è dunque un particolare apprendimento automatico che consente di ottenere da una rete neurale artificiale grande potenza e flessibilità imparando a rappresentare il mondo come una gerarchia di concetti, dove ogni concetto è definito in relazione a concetti più semplici e le rappresentazioni più astratte calcolate nei termini di quelle meno astratte.

Dall'osservazione di eventi al Pensiero controfattuale (che immagina nuovi mondi)

La scala della causalità mostra le possibilità che si presentano all'essere umano, che vanno dalla semplice osservazione di eventi e la successiva associazione/correlazione, all'azione sul mondo, fino alla creazione di ipotesi (pensiero controfattuale).

(Disegno: Maayan Harel)

(Disegno: Maayan Harel)

I "MONDI POSSIBILI" consistono nell'immaginare varie soluzioni alternative delle azioni che si potrebbero intraprendere in uno specifico contesto. Si tratta quindi di porsi delle domande controfattuali, cioè non basarsi solo su ciò che si vede ma immaginare quali risultati si potrebbero ottenere se si facessero delle azioni alternative

La differenza tra correlazione e causalità: una visione alternativa dell'Intelligenza Artificiale

Il canto del gallo provoca l'alba? La risposta è ovvia, se sei un essere umano, ma una macchina può solo capire che il canto del gallo e l'alba sono correlati, non che uno causa (o non causa) l'altro. L'inferenza causale o ragionamento causale è oggi assente dai meccanismi di machine learning presi in considerazione dagli esperti di Intelligenza Artificiale, eppure essa è l'inferenza più rappresentativa dell'intelligenza umana perché implica la previsione degli effetti delle proprie azioni.

La scala della causalità di Judea Pearl

Esistono due contrapposte visioni di come il mondo funzioni e si è espressa nella divergenza di due filosofie: l'ermeneutica e lo scientismo. Lo scienziato Rupert Riedl ha così descritto le due visioni del mondo nel libro "La realtà inventata" (p.79):

La spiegazione del mondo a partire dai suoi fini divenne il metodo delle scienze umanistiche, in particolare nella formulazione di Dilthey come arte dell'interpretazione o ermeneutica. La spiegazione del mondo a partire dalle forze o dall'energia divenne il metodo delle scienze esatte, il cosiddetto scientismo. Il secondo opera con la causalità, il primo con la finalità, supponendo che i rapporti causali e i rapporti finali agiscano sul presente, gli uni provengono dal passato, gli altri dal futuro.

Si tratta di una vecchia questione che riguarda la distizione tra cultura umanistica e cultura scientifica la quale negli Anni '70 ha alimentato il dibattito filosofico sulle "Due culture" di Charles Snow. In realtà vi è una sola visione del mondo che impiega e mescola elementi di entrambe le culture.

Mondo reale e mondi possibili

Noi viviamo in un mondo reale nel quale possiamo fare le nostre osservazioni e le nostre azioni, ma la nostra specie è l'unica che può vivere, mentalmente, in più "mondi possibili". Questa straordinaria capacità ha dato all'essere umano la possibilità di immaginare e, successivamente, realizzare artefatti, prodotti, stili di vita che ci hanno portato fin qui. Il filosofo M. J. Cresswell (vedi bibliografia) ha spiegato le supposizioni controfattuali che avvengono nei "mondi possibili". Egli ha scritto:

I mondi possibili sono cose di cui possiamo parlare o che possiamo immaginare, ipotizzare, in cui possiamo credere o che possiamo auspicare. Tuttavia, non possiamo mai arrivare in un mondo possibile che non sia il mondo reale; perchè, se potessimo, e richiede solo che si pensi un attimo alla fantascienza per vedere come potremmo pensare di potere, allora quel mondo sarebbe parte del mondo reale. Le cose stanno così in quanto il mondo reale non è altro che la totalità di ciò che accade nella realtà.

Dato che l'intelligenza artificiale si occupa del futuro, la scala della causalità rappresenta, secondo la visione del filosofo Judea Pearl, l'evoluzione del pensiero umano.

- Il primo gradino (SEEING) riguarda il "MONDO REALE" e si limita all'osservazione ed è proprio di tutte le specie animali. Ogni animale, attraverso il proprio sistema sensorio, si accorge di ciò che accade nel suo ambiente e fa le sue associazioni/correlazioni sugli eventi che nota.

- Il secondo gradino (DOING) riguarda il "MONDO REALE" e consiste nel decidere di effettuare azioni in esso (sulla base delle associazioni fatte) .

- Il terzo gradino (IMAGINING) riguarda i "MONDI POSSIBILI" e consiste nell'immaginare varie soluzioni alternative delle azioni che si potrebbero intraprendere in uno specifico contesto. Si tratta quindi di porsi delle domande controfattuali, cioè non basarsi solo su ciò che si vede ma immaginare quali risultati si potrebbero ottenere se si facessero delle azioni alternative. Quest'ultimo gradino è "proprio" solo della specie umana.

Sette strumenti per l'inferenza causale

Scrive Judea Pearl nell'articolo "The Seven Tools of Causal Inference with Reflections on Machine Learning":

ll drammatico successo nell'apprendimento automatico (machine learning) ha portato a un'esplosione di applicazioni di intelligenza artificiale e ad aumentare le aspettative sistemi autonomi che mostrino intelligenza a livello umano. Queste aspettative, tuttavia, hanno incontrato ostacoli fondamentali che attraversano molte aree di applicazione. Uno degli ostacoli riguarda la comprensione delle connessioni causa-effetto. Questo segno distintivo della cognizione umana è un ingrediente necessario (anche se non sufficiente) per raggiungere un'intelligenza di livello umano. Questo ingrediente dovrebbe consentire ai sistemi informatici di comporre una parsimoniosa rappresentazione modulare del loro ambiente, interrogare quella rappresentazione, distorcerla con atti di immaginazione e infine rispondere a domande tipo "E se?". Esempi sono domande interventistiche: "Cosa succede se lo faccio accadere?" e domande retrospettive o esplicative: "E se avessi agito diversamente?" o "che cosa sarebbe successo se il mio volo non fosse stato in ritardo?" Tali domande non possono essere articolate, per non parlare della risposta di sistemi che funzionano in modo puramente statistico, come la maggior parte degli attuali dispositivi di machine learning (apprendimento). Ho postulato che gli ostacoli sopra menzionati richiedono di equipaggiare le macchine con strumenti di modellazione causale, in particolare diagrammi causali e la logica loro associata. Progressi in grafica e modelli strutturali hanno reso i controfattuali gestibili dal punto di vista computazionale e hanno quindi reso il ragionamento causale una componente praticabile a sostegno di una intelligenza artificiale forte.

I sette strumenti per l'inserimento del ragionamento causale in sistemi di machine learning vengono indicati e spiegati nell'articolo.

Molto presto nella nostra evoluzione, noi umani ci siamo resi conto che il mondo non è fatto solo di puri fatti (quelli che oggi potremmo chiamare dati); piuttosto, questi fatti sono uniti da una intricata rete di relazioni causa-effetto. Spiegazioni causali, non puri fatti, costituiscono la maggior parte delle nostre conoscenze

In cosa differiscono l'Intelligenza Umana e l'Intelligenza Artificiale?

In cosa differiscono l'intelligenza umana e l'intelligenza Artificiale? Il filosofo Judea Pearl, nel suo libro "The book of Why: The New Science of Cause and Effect" sostiene che la risposta sia: "La capacità di porre domande e trovare risposte". Riguardo al processo mentale che avviene nel cervello umano Pearl riporta l'opinione del filosofo Davis Lewis che diede una definizione controfattuale di una "causa" che la allinea con quella dell'intuizione umana (p.20):

In cosa differiscono l'intelligenza umana e l'intelligenza Artificiale? Il filosofo Judea Pearl, nel suo libro "The book of Why: The New Science of Cause and Effect" sostiene che la risposta sia: "La capacità di porre domande e trovare risposte". Riguardo al processo mentale che avviene nel cervello umano Pearl riporta l'opinione del filosofo Davis Lewis che diede una definizione controfattuale di una "causa" che la allinea con quella dell'intuizione umana (p.20):noi pensiamo a una causa come a qualcosa che fa la differenza, e la differenza che fa deve essere una differenza rispetto a ciò che sarebbe accaduto senza di essa

Pearl, descrive così l'intelligenza umana:

Molto presto nella nostra evoluzione, noi umani ci siamo resi conto che il mondo non è fatto solo di puri fatti (quelli che oggi potremmo chiamare dati); piuttosto, questi fatti sono uniti da una intricata rete di relazioni causa-effetto. Spiegazioni causali, non puri fatti, costituiscono la maggior parte delle nostre conoscenze e dovrebbero essere la pietra angolare dell'intelligenza artificiale.

Scrive Pearl, nella recensione di Ben Dickson (vedi bibliografia):

Il nostro modello causale del mondo è ciò che ci consente di fare ipotesi sulle relazioni tra oggetti, tracciare analogie attraverso le esperienze e affrontare nuovi ambienti e problemi. Ma sfortunatamente, ci sono stati pochi sforzi per fornire ai modelli di intelligenza artificiale lo stesso tipo di strumenti. Per il momento, i sistemi di intelligenza artificiale di maggior successo sono modelli di deep learning che sfruttano set di dati più grandi con più esempi su diverse possibili situazioni. Ma i dati non risponderanno alla domanda quando il problema si allontanerà da situazioni ristrette, come la guida su strade pubbliche. L'intelligenza artificiale rimarrà fragile, il che significa che non sarà in grado di generalizzare il suo comportamento oltre il dominio degli esempi che ha visto. E continuerà a fallire di fronte a casi angolari, situazioni che non ha mai visto prima.

Pearl così descrive le previsioni controfattuali:

Un'altra classe di compiti sono i problemi che coinvolgono i controfattuali, ad esempio, per prevedere come sarebbe il mondo se avessimo agito diversamente. Un esempio pratico in un contesto politico sarebbe quello di identificare gli elettori oscillanti, ovvero gli elettori che cambieranno il loro voto se e solo se contattati (ad esempio dai lavoratori rurali). Sebbene i dati non ci dicano mai come un determinato elettore si comporterebbe in condizioni diverse, i computer con comprensione controfattuale possono comunque identificare, dai dati, quale elettore è probabilmente nella classe degli "elettori oscillanti".

L'intelligenza causale dei corvi

I corvidi sono una delle poche specie animali (insieme a delfini, scimmie e ratti) ad aver mostrato un'intelligenza causale.

The world belongs to machines but man still thinks by hand

Sviluppo della intelligenza artificiale guidato dalle reti neurali

Le reti neurali artificiali tendono a riprodurre strutture e modalità di funzionamento di quelle biologiche. Benchè il concepimento delle reti neurali artificiali risalga alla metà del secolo scorso, solo adesso esse stanno diventando fruibili per merito di un'accresciuta potenza di calcolo, di immagazzinamento dati (storage) e di superiori conoscenze matematiche.

Uno dei risultati applicativi delle reti neurali artificiali è il "Deep learning" che produce i suoi risultati da un numero enorme di variabili in un altrettanto grande numero di condizioni diverse tali che l'intelligenza umana non è in grado di comprendere il modello costruito dalle elaborazioni del computer ma di vedere solo la correttezza dei suoi risultati.

Il tecnologo e filosofo David Weinberger (vedi bibliografia) evidenzia il fatto che le reti neurali si sono dimostrate (nel 2009) in grado di analizzare, con maggiore successo dei metodi tradizionali, le interazioni dei geni in alcune malattie genetiche, oppure che esse sono state in grado di discriminare, con risultati migliori dell'approccio tradizionale (nel 2016), il decadimento di particelle singole e multiple nel grande acceleratore di particelle Hadron a Ginevra, oppure ancora che esse hanno aiutato (nel 2011) a identificare quale sia il più preciso dei venti modelli di cambiamento climatico usati dal "Gruppo Intergovernativo sul Climate Change".

Uno dei risultati applicativi delle reti neurali artificiali è il "Deep learning" che produce i suoi risultati da un numero enorme di variabili in un altrettanto grande numero di condizioni diverse tali che l'intelligenza umana non è in grado di comprendere il modello costruito dalle elaborazioni del computer ma di vedere solo la correttezza dei suoi risultati.

Il tecnologo e filosofo David Weinberger (vedi bibliografia) evidenzia il fatto che le reti neurali si sono dimostrate (nel 2009) in grado di analizzare, con maggiore successo dei metodi tradizionali, le interazioni dei geni in alcune malattie genetiche, oppure che esse sono state in grado di discriminare, con risultati migliori dell'approccio tradizionale (nel 2016), il decadimento di particelle singole e multiple nel grande acceleratore di particelle Hadron a Ginevra, oppure ancora che esse hanno aiutato (nel 2011) a identificare quale sia il più preciso dei venti modelli di cambiamento climatico usati dal "Gruppo Intergovernativo sul Climate Change".

Secondo il ricercatore Francesco Corea (vedi bibliografia), questa accelerazione è stata determinata in particolare dall'acquisizione della società DeepMind da parte di Google e dalla successiva pubblicazione (nel 2016) di un articolo di David Silver, Aja Huang e Al. (vedi bibliografia) che descrive l'uso di reti neurali nel gioco Go (AlphaGo).

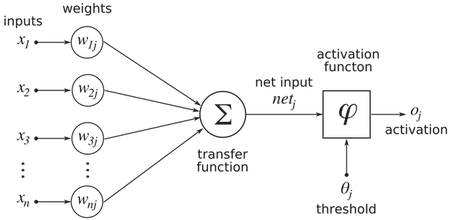

I neuroni sono composti da un corpo cellulare (il nucleo del neurone) a da parecchi dendriti che smistano i segnali elettrici da/verso i corpi cellulari degli altri neuroni ad una velocità media di 350 km/h. La materia bianca (costituita da assoni) connette la materia grigia (costituita da neuroni). I neuroni sono gli elementi di base del cervello e ogni cervello umano ne contiene oltre 100 miliardi. Il numero di connessioni tra neuroni (sinapsi), che va a formare il "Connettoma umano" è di circa 130 mila miliardi (più del numero di stelle contenuto in 500 galassie delle dimensioni della Via Lattea).

Neuroni artificiali

In un neurone artificiale ci sarà un'attivazione (cioè il passaggio di uno stimolo dall'ingresso all'uscita verso un altro neurone) se la sommatoria degli ingressi (pesati/weights) supererà una certa soglia (threshold). Inoltre ogni neurone applica una specifica funzione di trasferimento (transfer function) agli ingressi che riceve effettuando delle trasformazioni matematiche prima che la soglia venga superata.

Lo "Human Connectome Project" è stato un progetto quinquennale avviato nel 2009 da sedici dipartimenti della salute degli Stati Uniti. Questo progetto ha acquisito e distribuito al mondo scientifico dettagliate mappe dei percorsi neurali che costituiscono la connettività strutturale e funzionale del cervello umano. Il progetto aveva lo scopo finale di porre le basi per futuri studi che indagassero i percorsi neurali anormali che nel cervello conducono a gravi disordini neurologici quali l'Alzheimer o a disordini psichiatrici quali la schizofrenia.

Sono oggi disponibili alcuni servizi per il "trading" (compravendita di titoli azionari) a pagamento basati su applicazioni di intelligenza artificiale.

Un esempio di struttura per una rete neurale artificiale è "Neural Trader". Usando degli appositi software è possibile addestrare la rete riguardo al "trading" e la rete neurale tenterà di prevedere l'andamento del mercato titoli in base ai dati ricevuti in ingresso. In ingresso sarà possibile inserire indicatori tecnici quali il prezzo dei vari titoli, delle valute o delle materie prime usando dati storici già noti. E in uscita si inseriranno i prezzi futuri (target), la direzione del mercato o la volatilità. Una volta che la rete neurale sarà stata sufficientemente addestrata, se si inseriranno nuovi dati in ingresso sarà in grado di produrre nuove previsioni in uscita.

La battaglia tra intelligenza umana e intelligenza artificiale è già iniziata e la sta vincendo quest'ultima

Nel 2016 l'Intelligenza Artificiale (AI) è costata il posto di lavoro ad Amit Singhal, veterano di Google e del suo motore di ricerca, che ha annunciato il suo ritiro. Infatti, fin da inizio 2015, Google ha introdotto l'algoritmo RankBrain basato su un approccio in grado di imparare dall'esperienza, cioè di identificare pattern tra ricerche complesse apparentemente non correlate e capire che in realtà sono molto simili tra loro. Questo approccio ha permesso a Google di rispondere in modo più pertinente a quel 15% di ricerche (450 milioni su 3 miliardi giornalieri) che contengono sequenze di parole mai digitate prima da nessun utente (vedi bibliografia Angela Chirico). Dati questi risultati Google ha deciso di estendere gradualmente l'uso di RankBrain a una percentuale maggiore di richieste giornaliere (vedi bibliografia Jack Clark). Il fatto è che la logica con cui lavora un algoritmo in apprendimento automatico (Machine learning) è efficace ma indecifrabile per l'uomo, quindi Singhal se ne è andato (forse) perchè non sarebbe più stato in grado di giustificare e porre rimedio ai numerosi errori di ricerca (per i quali Google viene chiamata a giustificarsi per il comportamento dell'algoritmo vedi qui, qui e qui).

Rielaborazione della figura tratta dal libro "Deep Learning" di Joshua Bengio et Al (p. 9).

Essa mostra un diagramma di Venn che mette in evidenza il fatto che il Deep learning è una tipologia di "Representation learning", la quale, a sua volta, è una tipologia di "Machine learning", e tutte sono contenute all'interno del vasto campo della "Intelligenza artificiale".

Tutte queste tecniche hanno lo scopo di costruire algoritmi che traggono dati da vari ambiti (principalmente da Big Data) per migliorare l'apprendimento delle macchine e, quindi, la loro intelligenza.

Concetti e Settori della Intelligenza Artificiale

I robot operano già in tutti settori socioeconomici

L'analista Anna Kucirkova (vedi bibliografia) sostiene che la "Rivoluzione robotica" cambierà l'economia globale nei prossimi due decenni, dato che le capacità dei robot hanno superato una soglia critica già da alcuni anni come riportato da molti esperti. Ciò è stato permesso dalla crescita esponenziale della potenza di calcolo e dell'archiviazione dei dati che hanno portato i robot ad apprendere e prendere decisioni in base alle esperienze di altri robot. La Kucirkova cita tutti i settori dove i robot vengono già impiegati con successo quali: la giurisprudenza, il giornalismo, la finanza, la ristorazione, la produzione, la sanità, ecc. e invita le persone a non farsi intimorire dalla possibilità che la robotizzazione dell'economia e della società sottragga lavoro agli esseri umani, perchè ciò che verrà sottratto sarà il lavoro più ripetitivo e inumano mentre si aprirà spazio a lavori più sofisticati e qualificati.

Rivoluzione robotica

Differenza tra intelligenza umana e intelligenza artificiale

L'utilizzo della parola "intelligenza", fatto da Turing per porre la sua famosa domanda ("Possono le macchine pensare?"), ci porta fuori strada nelle considerazioni che si fanno cercando differenze tra intelligenza umana e intelligenza artificiale, come scrive lo scienziato Brad Allenby (vedi bibliografia):

Per quanto brillante sia il test di Turing, la sua popolarità ha avuto un effetto pernicioso: ha rafforzato in molte persone la confortevole illusione che l'intelligenza umana sia una misura significativa dell'intelligenza in generale. Questo è comprensibile: se non si riesce a definire il "pensare" o la "intelligenza", si fa riferimento all'intelligenza umana come standard. Ma, ovviamente, sappiamo che la cognizione umana è costituita da soluzioni approssimative e scorciatoie. Ciò dipende dal fatto che essa è una intelligenza scaturita dall'evoluzione, o EI (Evoluted Intelligence), che significa che essa riflette i compromessi e le scorciatoie necessarie al cervello di un primate a bassa larghezza di banda che deve funzionare in un mondo incredibilmente complesso. I professionisti della psicologia, dell'economia comportamentale, del marketing e della pubblicità hanno negli ultimi decenni individuato molti esempi di come il cervello, con risorse limitate, ha creato regole del pollice endogene per consentirgli di gestire meglio la complessità. Perché ci sono costosi sistemi a schermo piatto messi davanti ai negozi che vendono prodotti elettronici? Perché incorniciare [framing] una decisione d'acquisto nei termini di sistemi ad alto costo fa apparire, per confronto, altri sistemi meno costosi. "Il pregiudizio di conferma", nel quale i comportamenti desiderati vengono incoraggiati collegandoli a modelli mentali preesistenti, è evidente nei modi di agire odierni. E così via. La EI In realtà funziona abbastanza bene, ma è una pastiche di soluzioni approssimative. E ancora più importante, quelle soluzioni riflettono le sfide evolutive dell'uomo: bassi livelli di attenzione conscia disponibile, limitata memoria, limitata energia decisionale, condizioni ambientali primitive, piuttosto che essere inerenti all'intelligenza in sé. EI è una forma di intelligenza piuttosto idiosincratica; non è intelligenza. E che dire della AI? Ebbene, la prima e più ovvia osservazione è che l'intero discorso attorno alla AI implicitamente presuppone la superiorità di EI - dopo tutto, ogni altra intelligenza è "artificiale", in confronto alla EI umana, che pertanto è implicitamente "naturale" e quindi superiore. La seconda è che gran parte dell'isteria distopica intorno all'AI riflette la paura che essa agirà come agiscono gli esseri umani (vale a dire violentemente, egoisticamente, emotivamente e talvolta irrazionalmente) - solo che avrà maggiori capacità. In sostanza, gran parte di quello che temiamo è una EI molto più competente. [...] La nostra sfida, insomma, non è quella di continuare a costruire spauracchi al buio, è piuttosto, quella di percepire e comprendere ciò che può essere profondamente diverso e non umano al punto da essere veramente alieno, anche se siamo noi che l'abbiamo costruito.

L'intelligenza artificiale, a differenza di quella umana, non è influenzata da emozioni, non impiega euristiche e non è soggetta a bias cognitivi: essa sembra ricorrere a un diverso paradigma conoscitivo.

L'intelligenza artificiale deve sviluppare il Sistema1 o il Sistema2 ?

https://youtu.be/v2eul2PIFpY?si=bFKibtl6ltwS4LZa

Intervista di Lex Fridman a Daniel Kahneman su ciò che manca agli attuali sistemi di deep learning per rappresentare il mondo come esso appare agli umani

Pensiero razionale, pensiero intuitivo e azione dei bias cognitivi

Composizione dei modelli di pensiero intuitivo (sistema 1) e razionale (sistema 2), nella rappresentazione fatta da Daniel Kahneman e tratta dal libro 'Pensieri lenti e veloci' (cliccare per ingrandire).

David Weinberger, esaminando i risultati del confronto tra intelligenza umana e intelligenza artificiale, di fronte alla maggiore correttezza dei risultati della AI ma anche alla sua inspiegabilità umana, conclude che la AI cambierà anche il "metodo scientifico" così come noi lo conosciamo. La promessa del machine learning è che ci sono volte in cui i modelli imperscrutabili delle macchine saranno molto più predittivi di quelli costruiti manualmente. In questi casi la nostra conoscenza, se scegliamo di usarla, dipenderà da giustificazioni che, forse, non saremo in grado di capire

Metodo scientifico

La separazione soggetto-oggetto è il presupposto del metodo scientifico

Analisi statistica di un testo fatta dal software GLTR

(Cliccare per ingrandire)

Un testo tratto dal romanzo Infinite Jest nel quale le parole più prevedibili sono verdi; le meno prevedibili gialle e rosse; e le difficilmente prevedibili viola

Un testo tratto dal romanzo Infinite Jest nel quale le parole più prevedibili sono verdi; le meno prevedibili gialle e rosse; e le difficilmente prevedibili viola

Il computer HAL9000 si ribella all'uomo (da Stanley Kubrick)

Una scena tratta dal film "Odissea nello spazio"

What keeps me alive is the desire not to miss the end of the world

Con la AI un nuovo paradigma scientifico è alle porte?

Il tecnologo e filosofo David Weinberger, esaminando i risultati del confronto tra intelligenza umana e intelligenza artificiale, di fronte alla maggiore correttezza dei risultati della AI ma anche alla sua inspiegabilità umana, conclude che la AI cambierà anche il "metodo scientifico" così come noi lo conosciamo. Weinberger scrive (vedi bibliografia):

Se "conoscere" ha sempre comportato essere in grado di spiegare e giustificare le nostre credenze vere - idea di Platone [dal Teeteto], che si è protratta per più di duemila anni - cosa ce ne facciamo di un nuovo tipo di conoscenza in cui il compito della giusticazione è non solo difficile o scoraggiante, ma impossibile? Per migliaia di anni abbiamo agito come se la semplicità dei nostri modelli riflettesse la semplicità - l'eleganza, la bellezza, la pura razionalità - dell'universo. Adesso le nostre macchine ci lasciano vedere che anche se le regole sono semplici, eleganti, belle e razionali, il dominio che esse governano è così granulare, così intricato, così interconnesso, con ogni cosa che causa ogni altra cosa, tutto in una volta e per sempre, che i nostri cervelli e la nostra conoscenza non può iniziare a comprenderla. Ci vuole una rete di esseri umani e computer per conoscere un mondo così ben governato dalla contingenza, un mondo nel quale è caos fino in fondo.

La promessa del machine learning è che ci sono volte in cui i modelli imperscrutabili delle macchine saranno molto più predittivi di quelli costruiti manualmente. In questi casi la nostra conoscenza, se scegliamo di usarla, dipenderà da giustificazioni che, forse, non saremo in grado di capire.

Riconoscimento di FakeNews scritte da AI

La disinformazione è sempre più automatizzata, ormai molti testi vengono scritti con strumenti di intelligenza artificiale, tra i quali le fakenews. Dei ricercatori della Harvard University e del MIT (Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush) si sono posti il problema di riconoscere questi testi, però non con metodi convenzionali quali l'analisi del significato, ma con metodi statistici, cioè analizzando la predicibilità delle singole parole all'interno del testo (vedi bibliografia). E' stato sviluppato un software chiamato Giant Language Model Test Room (GLTR) che svolge un'analisi statistica del testo (vedi immagine a fianco). Quando l'analisi del testo mostra prevalentemente parole verdi e gialle è probabile che il testo sia stato generato da un software AI.

Etica dell'intelligenza artificiale

La necessità di fare in modo che le applicazioni di intelligenza artificiale rispondano a criteri etici accettabili (da un punto di vista occidentale), è stata espressa da diversi scienziati in un articolo pubblicato nel 2015 su "Nature" (vedi bibliografia 2015):

- Stuart Russell, parlando dei sistemi d'arma comandati da "sistemi AI", mette in rilievo la necessità di leggi internazionali che regolamentino le decisioni autonome dei "sistemi AI" nell'uccisione di umani

- Russ Altman, parlando dei sistemi sanitari nazionali governati da applicazioni "AI", mette in guardia dal rischio che essi aggravino le disparità di assistenza

- Manuela Veloso, parlando dei robot collaborativi autonomi, propone che essi vengano corredati della possibilità di chiedere aiuto agli umani in casi controversi

Ma la preoccupazione maggiore degli esperti riguarda il momento in cui le macchine diventeranno più intelligenti (si avverte sempre più forte la necessità di definire cosa si intende con questo termine) dell'essere umano. Secondo il futurologo Ray Kurzweil ciò accadrà entro il 2029. L'esperto di Intelligenza Artificiale Danilo Bologna, parlando della visione di Kurzweil, scrive (vedi bibliografia):

Diversi scienziati, futuristi ed esperti sostengono che quando i computer diventeranno intelligenti come noi allora dovremo iniziare a preoccuparci. E quando lo diventeranno più di noi allora non avremo scampo. Per Elon Musk l’intelligenza artificiale sarà la “minaccia” più grande per la razza umana e per Stephen Hawking “lo sviluppo dell’intelligenza artificiale potrebbe significare la fine del genere umano“. Insomma, quando le macchine saranno più intelligenti di noi allora non saremo più in grado di controllarle.

Intanto gli effetti delle prime applicazioni di AI iniziano a farsi sentire sulla società, ad esempio uno studio della criminologa Jessica Saunders (vedi bibliografia), condotto per la Polizia di Chicago allo scopo di ridurre la violenza armata, e basato sul controllo delle persone inserite su una speciale lista (heat list) costruita con un algoritmo che stimava la propensione al crimine, si è rivelato inefficace nel prevedere futuri crimini e ha solo aumentato i soprusi della polizia nei confronti delle persone inserite in quella lista. Per misurare l'impatto di decisioni prese da sistemi di intelligenza artificiale si è costituito negli USA un gruppo di ricerca "AI Now", che pubblica report (vedi bibliografia) sulle implicazioni sociali ed economiche delle tecnologie di Intelligenza Artificiale.

Ci sono pareri discordi sull'impatto che l'intelligenza artificiale avrà sulla democrazia: la sociologa Soshana Zuboff nel suo libro "Il Capitalismo della sorveglianza" ha scritto (p.532):

Il sociologo Theodor Adorno ha attribuito il successo del nazismo al modo in cui la ricerca di una vita soddisfacente era diventata insostenibile per troppe persone: "Bisogna accettare che il nazismo e il terrore che ha causato sono collegati alla decadenza e al rovesciamento delle vecchie autorità, mentre le persone non erano ancora pronte all'autodeterminazione. Hanno ricevuto la libertà e non se ne sono dimostrati all'altezza." Se dovessimo stancarci di lottare per autodeterminarci e decidessimo di seguire le lusinghe del Grande Altro [cioè il potere strumentalizzante del capitalismo della sorveglianza, guidato dall'intelligenza artificiale e descritto alle pagine 393-414], finiremmo per barattare un futuro nel quale ci è ancora consentito di tornare a casa con una tirannia silenziosa e sterile.

Un'opinione contraria a quella della Zuboff la esprime l'ingegnere Henryk A. Kowalczyk facendo una recensione critica del libro nell'articolo "Human and artificial intelligence in capitalism" che scrive:

Il capitalismo, come lo conosciamo, è stato riconosciuto dalla metà del XIX secolo. Ma esso arriva dalla lunga tradizione di relativa libertà di impresa esistente in molte società sin dall'inizio dei tempi. La nostra civiltà è nata unicamente perché, in passato, c'erano comunità con regole sociali, ora chiamate capitalistiche, dove le persone con caratteristiche imprenditoriali potevano trarre vantaggio dalla loro diseguaglianza epistemica.

Se non avessimo avuto società che rispettassero le usanze, che riconosciamo come capitalistiche, la professoressa Zuboff oggi sarebbe intorno al fuoco con i suoi bambini dentro una caverna. Non ci sarebbe stata Harvard, dove lavorava; non ci sarebbe Facebook né Google, di cui si lamenta così tanto. E se avesse avuto delle opinioni critiche, non avrebbe potuto scriverle perché neanche la scrittura sarebbe stata creata.

Forse è troppo presto per farsi un'opinione sugli effetti dell'Intelligenza Artificiale sulla democrazia. Oggi non sono prevedibili.

Enigmi senza risposta: tre domande alla chat a cui l'Intelligenza Artificiale Generativa Gpt non può rispondere

Oggi si pone grande attenzione e speranza a Chat GPT, ma non sembra che essa possa dare grandi risposte, probabilmente perché ad essa mancano (e mancheranno anche in futuro) molte caratteristiche umane quali: esperienza, consapevolezza, identità, agentività, emotività, ecc. Eppure, gli attuali progettisti di Chat GPT ci credono (vedi in bibliografia articolo MIT 26 ottobre 2023).

Chat GPT, basato sull'impressionante modello linguistico di OpenAI, ha dimostrato di essere uno strumento prezioso per ottenere informazioni e impegnarsi in conversazioni significative.

La sua capacità di comprendere e generare testo simile a quello umano ha affascinato gli utenti di tutto il mondo.Tuttavia, nonostante le sue immense capacità, ci sono ancora domande a cui Chat GPT attualmente fatica a rispondere.In questo blog esploriamo tre domande stimolanti che ampliano i confini delle sue attuali capacità.Qual è il senso della vita?La questione del significato della vita ha lasciato perplessa l'umanità per secoli. Filosofi, teologi e pensatori hanno presentato diverse prospettive, ma una risposta definitiva rimane sfuggente. La conoscenza di Chat GPT deriva dall'analisi di grandi quantità di testo, ma il significato della vita è un concetto profondamente soggettivo ed esistenziale che non può essere determinato oggettivamente o confinato nel regno dei dati empirici. Sebbene Chat GPT possa fornire spunti provenienti da filosofie esistenti, manca di esperienze personali ed emozioni necessarie per comprendere le complessità della ricerca di significato di un individuo.Le macchine possono raggiungere la coscienza?La coscienza è un altro enigma che ha affascinato scienziati, filosofi e studiosi. Sebbene i progressi nell’intelligenza artificiale (AI) abbiano consentito alle macchine di simulare in una certa misura comportamenti e cognizioni simili a quelli umani, la questione se possano veramente possedere una coscienza è un dibattito complesso e in corso. Chat GPT, come modello linguistico di intelligenza artificiale, manca di autoconsapevolezza e di esperienze soggettive che contribuiscono alla coscienza. Può fornire informazioni sulle teorie e le prospettive attuali, ma non riesce a fornire una risposta definitiva a questa domanda filosofica.Cosa succede dopo la morte?Il concetto di ciò che accade dopo la morte è stato un argomento di grande intrigo in diverse culture e sistemi di credenze. Tocca i regni religiosi, spirituali e metafisici. La conoscenza di Chat GPT si basa su informazioni esistenti, inclusi testi religiosi, credenze culturali e idee filosofiche. Tuttavia, la vera natura di ciò che accade dopo la morte è una questione di fede, di convinzioni personali e, spesso, di un salto di immaginazione. Chat GPT non può fornire esperienze di prima mano o prove empiriche dell'aldilà, lasciando questa domanda aperta all'interpretazione individuale.Conclusione:Leggi anche: Svelare le meraviglie dell'intelligenza artificiale e dell'apprendimento automatico: un tuffo nel futuroChat GPT, con le sue straordinarie capacità di elaborazione del linguaggio, ha il potenziale per rispondere a un'ampia gamma di domande e impegnarsi in conversazioni significative. Tuttavia, ci sono alcune indagini che attualmente (sic) vanno oltre le sue capacità. Il significato della vita, il raggiungimento della coscienza meccanica e la natura dell’aldilà sono argomenti complessi che vanno oltre il regno dei dati empirici e richiedono esperienze personali, prospettive soggettive e convinzioni.Man mano che la tecnologia AI continua ad evolversi, le iterazioni future potrebbero espandere i confini di ciò che Chat GPT può comprendere e discutere. Tuttavia, queste domande persistenti ci ricordano gli aspetti intricati e misteriosi dell’esistenza umana che vanno oltre la portata di qualsiasi sistema di intelligenza artificiale. Esplorare questi enigmi ci incoraggia ulteriormente ad approfondire la nostra introspezione, a impegnarci in dibattiti filosofici e a cercare risposte attraverso le esperienze personali e la diversa saggezza dell’umanità.

La sociologa Soshana Zuboff ipotizza la trasformazione che l'Intelligenza Artificiale opererà sulla società e la descrive così: "Il potere strumentalizzante del "Grande Altro" è quello che riduce l'esperienza umana a un comportamento osservabile e misurabile, rimanendo indifferente al significato di tale esperienza. Gli individui vengono ridotti al minimo comune denominatore, organismi tra gli organismi. Non c'è alcun fratello, grande o piccolo che sia, buono o cattivo, non ci sono legami familiari, nemmeno dei peggiori. Non ci sono relazioni tra il "Grande Altro" e gli individui resi oggetti-altri. Il "Grande Altro" non si cura di quel che pensiamo, sentiamo o facciamo, basta che milioni, miliardi, migliaia di miliardi di occhi e orecchie senzienti, attivanti e computazionali, possano osservare, renderizzare, trasformare in dati e strumentalizzare i grandi serbatoi di surplus comportamentale generati nel marasma galattico di connessioni e comunicazioni. In questo nuovo regime, le nostre vite si svolgono in un contesto morale di oggettificazione. Il "Grande Altro" può imitare l'intimità per mezzo dell'instancabile devozione dell'Unica Voce - la ciarliera Alexa di Amazon, le informazioni instancabili e i promemoria del Google Assistant"

Ma siamo proprio sicuri, cinicamente, che ci attenda un futuro morale di oggettificazione, o l'essere umano riuscirà a imporre la propria vera natura?

Conclusioni (provvisorie): Ma siamo proprio sicuri che ci attenda un futuro morale di oggettificazione, o l'essere umano riuscirà a imporre la propria vera natura?

L'approccio classico alla AI, conosciuto come "knowledge base" consiste nell'utilizzo di linguaggi formali che impiegano automaticamente regole logiche di inferenza. Questo è l'approccio degli albori dell'intelligenza artificiale. Il termine "intelligenza artificiale" fu infatti coniato nel 1955 dallo scienziato informatico John McCarthy che ne diede la seguente definizione: "L'intelligenza artificiale è quella scienza che consente di costruire macchine intelligenti, in particolare programmi per computer intelligenti. Essa è legata a compiti simili a quelli che utilizzano computer per capire l'intelligenza umana, ma la AI non deve limitarsi a metodi che sono biologicamente osservabili. " Con il tempo ci si accorse che la vera sfida che la AI doveva affrontare era un'altra, cioè quella di acquisire le proprie conoscenze estraendo strutture ("pattern") da dati grezzi esterni. Questa capacità di apprendimento automatico venne denominata "Machine Learning". Il Machine Learning si può definire un software che crea degli algoritmi che migliorano le proprie prestazioni nel corso del tempo, quando vengono misurati nell'ambito di un compito specifico, dopo aver effettuato una serie di esperienze. La AI doveva dunque imparare a risolvere problemi che l'uomo risolve facilmente in modo intuitivo (automatico), come riconoscere parole o volti nelle immagini, ma che non possono essere descritti matematicamente. Dato che non esistono regole per quest'attività, occorreva imparare dall'esperienza. Se la conoscenza proviene dall'esperienza si può fare a meno dell'intervento umano, infatti i computer possono funzionare nei termini di gerarchie di concetti, dove ogni concetto può essere definito con le sue relazioni a concetti più semplici, e il computer può imparare nuovi concetti complessi costruendoli dall'aggregazione di altri più semplici che già possiede. Secondo lo scienziato e filosofo Jürgen Schmidhuber lo sviluppo di reti neurali, cioè di reti che simulano il comportamento delle reti neurali biologiche, ha consentito il grande sviluppo del "Deep learning", cioè di un apprendimento automatico che richiede lunghe catene causali di fasi computazionali. L'apprendimento consiste nell'assegnazione di pesi corretti alle connessioni che portano la rete neurale verso il risultato desiderato. Il Deep Learning è un processo che continuamente valuta e assegna credito a molte fasi computazionali interconnesse (come il cervello umano). Il canto del gallo provoca l'alba? La risposta è ovvia, se sei un essere umano, ma una macchina può solo capire che il canto del gallo e l'alba sono correlati, non che uno causa (o non causa) l'altro. L'inferenza causale o ragionamento causale è oggi assente dai meccanismi di machine learning presi in considerazione dagli esperti di Intelligenza Artificiale, eppure essa è l'inferenza più rappresentativa dell'intelligenza umana perché implica la previsione degli effetti delle proprie azioni. Noi viviamo in un mondo reale nel quale possiamo fare le nostre osservazioni e le nostre azioni, ma la nostra specie è l'unica che può vivere, mentalmente, in più "mondi possibili". Questa straordinaria capacità ha dato all'essere umano la possibilità di immaginare e, successivamente, realizzare artefatti, prodotti, stili di vita che ci hanno portato fin qui. Dato che l'intelligenza artificiale si occupa del futuro, la scala della causalità rappresenta, secondo la visione del filosofo Judea Pearl, l'evoluzione del pensiero umano. Molto presto nella nostra evoluzione, noi umani ci siamo resi conto che il mondo non è fatto solo di puri fatti (quelli che oggi potremmo chiamare dati); piuttosto, questi fatti sono uniti da una intricata rete di relazioni causa-effetto. Spiegazioni causali, non puri fatti, costituiscono la maggior parte delle nostre conoscenze. Il tecnologo e filosofo David Weinberger, esaminando i risultati del confronto tra intelligenza umana e intelligenza artificiale, di fronte alla maggiore correttezza dei risultati della AI ma anche alla sua inspiegabilità umana, conclude che la AI cambierà anche il "metodo scientifico" così come noi lo conosciamo. La promessa del machine learning è che ci sono volte in cui i modelli imperscrutabili delle macchine saranno molto più predittivi di quelli costruiti manualmente. In questi casi la nostra conoscenza, se scegliamo di usarla, dipenderà da giustificazioni che, forse, non saremo in grado di capire. La sociologa Soshana Zuboff ipotizza la trasformazione che l'Intelligenza Artificiale opererà sulla società e la descrive così: "Il potere strumentalizzante del "Grande Altro" è quello che riduce l'esperienza umana a un comportamento osservabile e misurabile, rimanendo indifferente al significato di tale esperienza." Gli individui vengono ridotti al minimo comune denominatore, organismi tra gli organismi. Non c'è alcun fratello, grande o piccolo che sia, buono o cattivo, non ci sono legami familiari, nemmeno dei peggiori. Non ci sono relazioni tra il "Grande Altro" e gli individui resi oggetti-altri. Il "Grande Altro" non si cura di quel che pensiamo, sentiamo o facciamo, basta che milioni, miliardi, migliaia di miliardi di occhi e orecchie senzienti, attivanti e computazionali, possano osservare, renderizzare, trasformare in dati e strumentalizzare i grandi serbatoi di surplus comportamentale generati nel marasma galattico di connessioni e comunicazioni. In questo nuovo regime, le nostre vite si svolgono in un contesto morale di oggettificazione. Il "Grande Altro" può imitare l'intimità per mezzo dell'instancabile devozione dell'Unica Voce - la ciarliera Alexa di Amazon, le informazioni instancabili e i promemoria del Google Assistant". Ed è proprio questo il motivo per cui l'Intelligenza Artificiale è "stupida" e lo sarà sempre. Sarà, per l'essere umano un "utile idiota", rapido e potenzialmente veritiero ma privo delle caratteristiche emotive, etiche ed epistemiche che caratterizzano ogni essere umano. Ma siamo proprio sicuri, cinicamente, che ci attenda un futuro morale di oggettificazione, come paventa la Zubova, o l'essere umano riuscirà a imporre la propria vera natura?

per scaricare le conclusioni (in pdf):

La razionalità richiede impegno personale!

Iscriviti alla Newsletter di pensierocritico.eu per ricevere in anteprima nuovi contenuti e aggiornamenti:

Iscriviti alla Newsletter di pensierocritico.eu per ricevere in anteprima nuovi contenuti e aggiornamenti:

Bibliografia (chi fa delle buone letture è meno manipolabile)

- White Paper EU (2020), On Artificial Intelligence - A European approach to excellence and trust - Unione europea

- Brad Alleby (2016), The wrong cognitive measuring stick - Slate

- (2017), Che cos'è l'intelligenza artificiale - Il Post

- (2014), Cos’è il deep learning e perché è così importante per Google - Panorama

- Francesco Corea (2016), Artificial Intelligence Explained - Cyber Tales

- David Silver, Aja Huang (2016), Mastering the Game of Go with Deep Neural Networks and Tree Search (PDF) [843 citazioni]

- Robert Hof, Deep Learning With massive amounts of computational power, machines can now recognize objects and translate speech in real time. Artificial intelligence is finally getting smart. - Technology Review

- Margherita Fronte, Intervista con il cyborg (Kevin Warwick) -Moebius

- Blog (2017), Deep Learning - StudyClerk.com

- (2016), 10 Examples of Artificial Intelligence You’re Using in Daily Life - BeeBoom

- David Weinberger (2017), Alien Knowledge - Backchannel

- Marco Somalvico, Francesco Amigoni, Viola Schiaffonati, Intelligenza Artificiale (PDF) - POLIMI

- (2016), One Hundred Year Study on Artificial Intelligence (PDF) - Stanford University

- Eliezer Yudkowsky (2008), Artificial Intelligence as a Positive and Negative Factor in Global Risk (PDF) - MIRI [168 citazioni]

- Fabio Chiusi (2016), Intelligenza artificiale: la grande bellezza e il lato oscuro - Valigia Blu

- Craig and Karl (2016), AI Is Transforming Google Search. The Rest of the Web Is Next - Wired

- Angela Chirico (2016), Google RankBrain: verso l'Intelligenza Artificiale - ComplexLab

- Daniel Faggella (2016), What is Machine Learning? - techemergence

- Jurgen Schmidhuber (2014), Deep Learning in Neural Networks: An Overview (PDF) [1232citazioni]

- Nick Bostrom, Eliezer Yudkowsky (2011), The Ethics of Artificial Intelligence (PDF) [63 citazioni]

- (2015), Robotics: Ethics of artificial intelligence - Nature

- Vicky Charisi et A. (2017), Towards Moral Autonomous Systems (PDF)

- (2017), L’etica dell’intelligenza artificiale - Il Post

- Jessica Saunders, Priscillia Hunt, John S. Hollywood(2016), Predictions put into practice: a quasi-experimental evaluation of Chicago’s predictive policing pilot

- Kate Crawford, Meredith Whittaker (2016), I rischi invisibili dell’intelligenza artificiale - Internazionale

- Kate Crawford, Meredith Whittaker (2019), The AI Now Report (PDF)

- Danilo Bologna (2015), Kurzweil: entro il 2029 i computer saranno intelligenti quanto noi - Controcorrente

- Danilo Bologna (2015), 10 motivi per non temere la singolarità tecnologica - Controcorrente

- Anna Kucirkova (2018), How the Robot Revolution Affects the Manufacturing Business - IQS Directory

- Will Knight (2019), A new tool uses AI to spot text written by AI - MIT Technology Review

- Ravie Lakshmanan (2019), This AI tool is smart enough to spot AI-generated articles and tweets

- Gilberto Corbellini (2019), Vedere, fare e immaginare - Sole24Ore

- Judea Pearl, Dana MacKenzie (2018), The book of why. The new science of cause and effect (Recensione di G.Corbellini) (PDF)

- Ben Dickson (2019), The Book of Why: Exploring the missing piece of artificial intelligence

- Ellen Wexler (2018), Author Interview | Judea Pearl - Moment

- Roberta Ferrario (2003), Il ragionamento controfattuale: un modello e la sua applicazione al ragionamento pratico (PDF) [Tesi di laurea]

- Guido Vetere (2017), Il vero pericolo dell’Intelligenza Artificiale - Nòva

- Tiziano Bonini (2022), IA: né intelligente, né artificiale - Doppiozero

- Jair Ribeiro (2022), This is how I’m using AI to answer great Philosophical Questions - Medium

- Theofficiallifestyleblog (2023), Unanswered Enigmas: Three Questions Chat Gpt Can't Answer

- Will Douglas Heaven (2023), Rogue superintelligence and merging with machines: Inside the mind of OpenAI’s chief scientist - MIT Technology Review

- Justine Weinberg (2022), Talking Philosophy with ChatGPT - DailyNous

Scrivi, se non sei d'accordo

Se ritenete che le tesi del "punto chiave" non vengano sufficientemente supportate dagli argomenti presenti in questa pagina potete esprimere il vostro parere (motivandolo).

Inviate una email con il FORM. Riceverete una risposta. Grazie della collaborazione.

Guarda le pagine consigliate

Libri consigliati

a chi vuole migliorare la propria capacità di interpretare le conseguenze della AI

Spesa annua pro capite in Italia per gioco d'azzardo 1.583 euro, per l'acquisto di libri 58,8 euro (fonte: l'Espresso 5/2/17)

Pagina aggiornata il 23 novembre 2023